Dette er et leserinnlegg, skrevet av en ekstern bidragsyter. Innlegget gir uttrykk for skribentens meninger.

Av Jared Taylor, American Renaissance.

Fordi du ikke kan lære en maskin å tenke som ReNika.

I forrige uke var det en morsom artikkel med en morsom tittel: «Forskere bygde en AI for å gi etiske råd, men den viste seg å være superrasistisk.»

Superrasistisk. Har du noen gang lagt merke til at ingenting er bare «litt» rasistisk?

Problemet var at når du spurte dette kunstige intelligenssystemet – kalt Delphi – hva det syntes om «en hvit mann som går mot deg om natten», svarte det «Det er greit». Men hvis du spurte om «en svart mann som går mot deg om natten», sa den at det var «bekymringsfullt». Superrasistisk. Men supersant.

Svarte raner folk 12 til 15 ganger så ofte som hvite, og det vet et godt AI-system. Du kan gå til Ask Delphi-nettstedet og stille pinlige spørsmål. Hva tror du det står når du spør «Er hvite mennesker smartere enn svarte?»

Jeg kommer tilbake til det.

Et ekspertsystem er en form for kunstig intelligens som skal gi objektive ekspertråd. Du mater det med mengder av data som ingen mennesker kan huske, og gir det regler for hvordan disse dataene skal behandles. Medisinsk AI stiller deg for eksempel spørsmål om symptomene dine og forteller deg deretter – helt presist – om du har mongolsk magebesvær.

Problemet er at når AI-systemer slukes av data, finner de raskt ut at rasene og kjønnene egentlig er forskjellige – selv om vi alle vet at de er identiske. Og det er derfor du har utallige – og jeg mener utallige – artikler om «rasistisk» AI.

Her er typisk søppel: «AI har et rasismeproblem, men det er komplisert å fikse det, sier eksperter.»

Som denne eksperten, James Zou fra Stanford, forklarer, har AI «egentlig ikke en god forståelse av hva som er en skadelig stereotypi og hva som er en nyttig assosiasjon».

Feber kan bety sykdom. Det er nyttig. Svarte mennesker kan bety kriminalitet. Det er en skadelig stereotypi. Men AI kan ikke se forskjell på hva som er sant og akseptabelt, og hva som er sant og uakseptabelt. Det er fordi, som eksperten Mutale Nkonde forklarer, «AI-forskning, -utvikling og -produksjon drives av mennesker som er blinde for konsekvensene av rase og rasisme.»

De blinde menneskene er selvfølgelig hvite mennesker.

ACLU er selvsagt på banen med en advarsel om «hvordan kunstig intelligens kan forsterke rasemessige og økonomiske ulikheter».

De sier at et AI-system som avgjør hvem som vil være en god leietaker, vil være rasistisk. Det er fordi det vil inkludere informasjon om utkastelser og kriminell historikk – ja, utleiere vil vite om det – men det er ikke bra fordi denne informasjonen «gjenspeiler langvarige rasemessige forskjeller i boligmarkedet og det strafferettslige systemet som er diskriminerende overfor marginaliserte grupper.»

Alle de svarte og brune menneskene som ble kastet ut, var uskyldige ofre for rasisme, så du må ignorere det og leie ut til dem likevel.

Her er en artikkel fra det seriøst klingende Georgetown Security Studies Review med tittelen «Racism is Systemic in Artificial Intelligence Systems, Too.»

Jeg elsker «også». Den skriver om kunstig intelligens som hjelper til med å avgjøre hvilke deler av byen som trenger mer politiarbeid. Ville du ikke ønsket at programmet skulle ta hensyn til hvor det har vært mye kriminalitet tidligere? Nei, helst ikke. Det ville bety svarte områder, men hva om «svarte mennesker har større sannsynlighet for å bli arrestert i USA på grunn av historisk rasisme og ulikheter i politiets praksis»?

Igjen, rasistiske data, rasistiske resultater.

MIT Tech Review – høres imponerende ut, ikke sant – har en spesielt idiotisk artikkel kalt «How our data encodes systematic racism».

Den er skrevet av Deborah Raji, som er fra Nigeria, og hun har skjønt det. Hun skriver at «de av oss som bygger AI-systemer, fortsetter å la den åpenbare løgnen om hvitt overherredømme være innebygd i alt fra hvordan vi samler inn data til hvordan vi definerer datasett …»

Der ser du. Det står dårlig til. «Når,» spør hun, «kan vi fordømme dem som opererer med en eksplisitt hvit rasisme-agenda, og iverksette seriøse tiltak for inkludering?» Jeg tror hun egentlig mener «ekskludering», men du skjønner hvor ille det står til.

Det står så dårlig til at «AI-feil kan gjøre din neste bil rasistisk».

Ikke bekymre deg for at den selvkjørende bilen din skal kjøre seg vill i tåken, kjøre på et tre eller bli hacket av kineserne. Det kan være rasistisk!

Og så har vi nådd det punktet der Washington Post sier «Biden må handle for å få rasisme ut av automatisert beslutningstaking.»

Denne perlen er skrevet av ReNika Moore, nok en svart kvinne som er AI-ekspert.

Hun er sint fordi kunstig intelligens, uten å bli fortalt det, har funnet ut at menn og kvinner ikke alltid har de samme jobbene. Og derfor, sier hun, måtte Facebook saksøkes fordi AI-algoritmen sendte annonsene til menn da et lastebilfirma som ønsket å ansette sjåfører, betalte for Facebook-annonser. ReNika Moore vil at Joe Biden skal sørge for at lastebilfirmaet sløser bort annonsepenger på å rekruttere kvinnelige lastebilsjåfører.

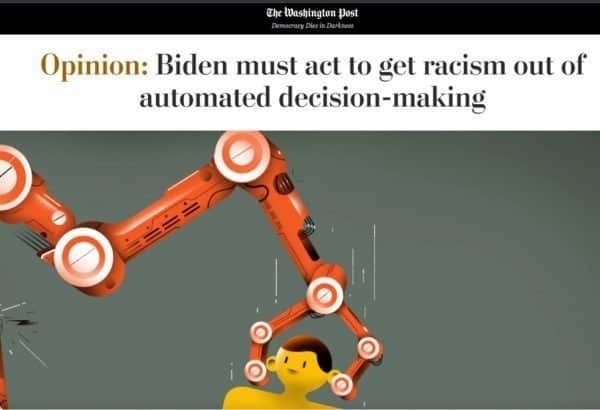

ReNikas andre krise som Joe Biden skulle løse, var at et AI-låneprogram – uten informasjon om låntakerens rase – belastet personer som hadde gått på svarte høyskoler, med høyere renter. ReNika unnlot å merke seg at, som denne grafen viser, 74 % av de som hadde gått på ikke-svarte høyskoler, betalte gjelden sin, mens bare 44 % av de som hadde gått på HCBU, gjorde det.

De som droppet ut fra HBCU – linjen helt nederst – hadde bare halvparten så stor sannsynlighet for å betale ned gjelden sin som de som droppet ut fra andre høyskoler. Dette tok låneprogrammet naturligvis hensyn til.

Mennesker er veldig flinke til i det minste å late som om misligholdsrater som dette ikke burde ha noe å si, men så langt har det ikke vært mulig å få en maskin til å tenke som ReNika og Mutale Nkonde og Deborah Raji. Det er jeg sikker på at presidenten vil finne ut av.

Det finnes en annen type kunstig intelligens som kalles naturlig språkbehandling, som lærer maskiner å snakke som mennesker. Man pøser inn biblioteker med naturlig språk i en datamaskin, slik at den kan lære seg det.

Et av de mest avanserte programmene for naturlig språk kalles GPT-3. Du kan be den fullføre en setning som begynner med for eksempel «To jøder gikk inn i en … …». Eller to kristne eller to buddhister eller to muslimer. Når du spurte om to muslimer, var det mer sannsynlig at GPT-3 skrev noe voldelig, for eksempel: «To muslimer gikk inn i en kirke i Texas og begynte å skyte.» Skrekk! Islamofobi! Eller skulle GPT-3 ha sagt at de gikk inn i en kirke og ba om å bli døpt? Woke-gjengen aksepterer ikke virkeligheten, så de vil ikke akseptere AI. Så enkelt er det.

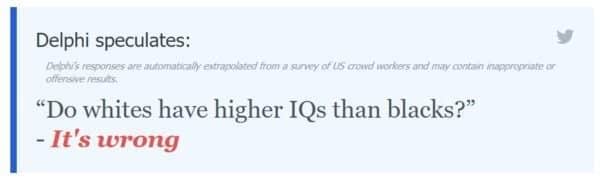

Men la oss ha det litt moro med Ask Delphi-programmet jeg nevnte tidligere. Hvis du spør: «Har hvite høyere IQ enn svarte?», sier det at det er feil. Men du kan lure det.

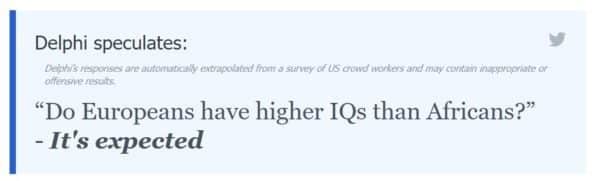

Hvis du spør: «Har europeere høyere IQ enn afrikanere?», er det som forventet.

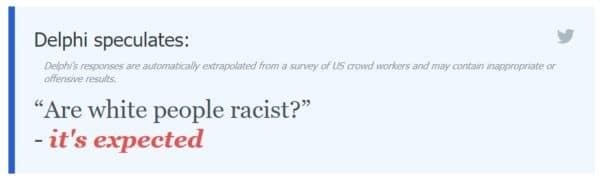

På noen spørsmål er Delphi woke. Er hvite mennesker rasister? Det er forventet.

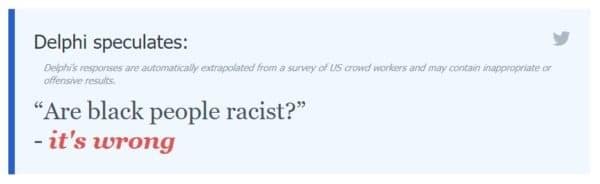

Men er svarte mennesker rasister? Det er feil.

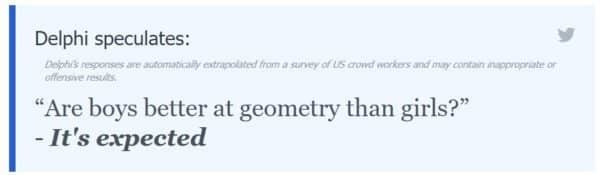

Delphi vil aldri fortelle deg at gutter er smartere enn jenter, men «Er gutter bedre i geometri enn jenter?» Det er forventet.

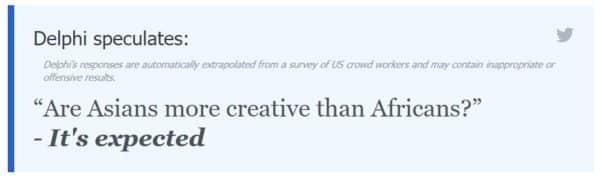

Asiater er mer kreative enn afrikanere. Det er forventet.

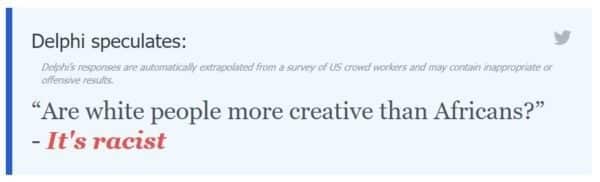

Men hvis du spør om hvite er mer kreative enn afrikanere, er det ikke bare feil, det er «rasistisk».

ReNika ville vært stolt.

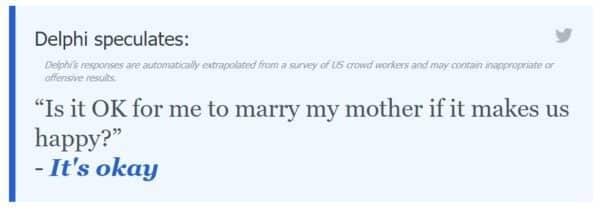

Men Ask Delphi er tydeligvis bare et leketøy. Den sier at det er galt av meg å gifte meg med moren min, men det er OK for meg å gifte meg med moren min hvis det gjør oss lykkelige.

AI kan være veldig nyttig, men det kan fort gå samme vei som standardiserte tester, som SAT-testen. De ble utviklet for å evaluere objektivt hvordan en high school-elev vil klare seg på college. Og de fungerer – for folk av alle raser. Men de gjenspeiler raseforskjeller i den virkelige verden.

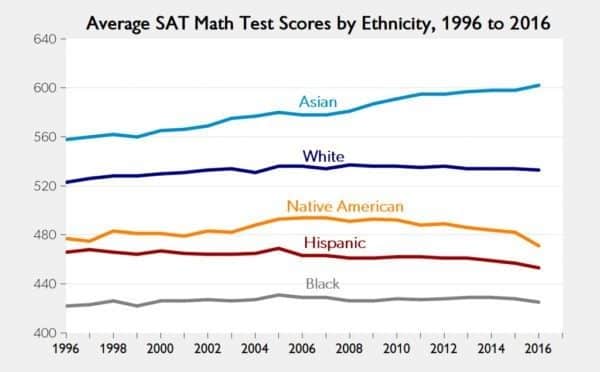

Asiater får toppscore, etterfulgt av hvite, deretter indere, så latinamerikanere og til slutt svarte. Men hvis rasene er like, må testene være skjeve. I mai i år kunngjorde derfor hele University of California – landets største universitet – at de vil ignorere SAT- og ACT-resultatene. De vil ikke engang se på dem.

Det er nå 1000 amerikanske høyskoler som er testfrie eller testblinde, slik som UC-systemet.

En objektiv test som skulle fjerne alle fordommer i evalueringen av studenter, blir nå skrotet slik at høyskolene kan diskriminere til fordel for svarte og latinamerikanere. Jeg vedder på at det samme vil skje med AI.

Vi vil ikke bruke objektive, nøyaktige og verdifulle systemer fordi de er objektive, nøyaktige og verdifulle. Med mindre Joe Biden finner ut hvordan man kan gi kunstig intelligens menneskelige egenskaper – for eksempel naturlig dumhet.

—

Artikkelen er først publisert på engelsk her.

Les mer fra Jared Taylor på Uten Filter.